「責任あるAI」という言葉をご存知だろうか。AI(人工知能)は既に社会の様々な場面で実装されているが、AIが下す判断の多くは人間にとってブラックボックスであり、その根拠を検証できない。結果的に、例えば特定の人種や性別の人間だけが企業の採用評価で低いスコアを受けるといった事態が起こり得る。差別や偏見が、AIのアルゴリズムによって温存され助長されるのだ。「責任あるAI」とはこうした問題を改善し、AIの透明性の向上を目指す概念である。

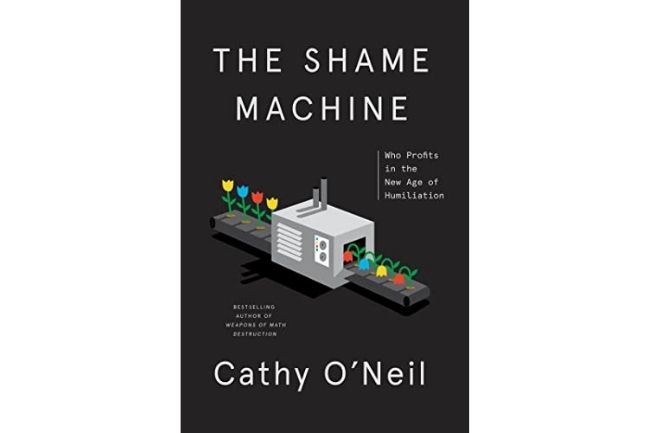

こうしたAIの不公正の問題にいち早く警鐘を鳴らしていたのが、データサイエンティストであり数学者であるキャシー・オニールである。前著『あなたを支配し、社会を破壊する、AI・ビッグデータの罠』(インターシフト刊)で彼女は上記の問題を指摘した。オニールは「有害なアルゴリズム」を第三者として監査する機関を設立し、CEO(最高経営責任者)も務めている。

「フォーサイト」は、月額800円のコンテンツ配信サイトです。簡単なお手続きで、サイト内のすべての記事を読むことができます。

フォーサイト会員の方はここからログイン