すでに実戦で使用されているAI兵器

2022年2月に勃発したロシア・ウクライナ戦争は、3年を過ぎ、なお継続中である。2023年10月に再発したイスラエル・ハマス戦争は、恒久的な停戦合意に達していない。それらの戦場では、実験場の如く、新たな技術や兵器が大量に投入されてきた。AI(人工知能)もそうである。たとえば、AIの意思決定支援システム(AI-DSS)として、ウクライナ軍はAIが敵・味方の戦況のビッグ・データを基に効率的な攻撃法を提言する「ゴッサム」システムを、イスラエル軍はAIが物的標的をリスト化する「ハブソラ」システム、人的標的をリスト化する「ラベンダー」システムおよびその人的標的を追跡する「パパはどこ?」システムを活用している。

さらに、ウクライナ軍は、2023年9月以降、機械学習に基づき、戦車・兵員輸送車などの装備を含む64種類の軍事標的を識別できるAI視覚ソフトウェア搭載のウクライナ・セイカー社のスカウト・ドローンを投入している。しかも、それは、偵察モードだけでなく、攻撃モードで小規模ながら実際に自律攻撃をしたという。その自律能力を疑問視する意見もあるが、完全自律型攻撃ドローンが出現間近なことだけは確かである。

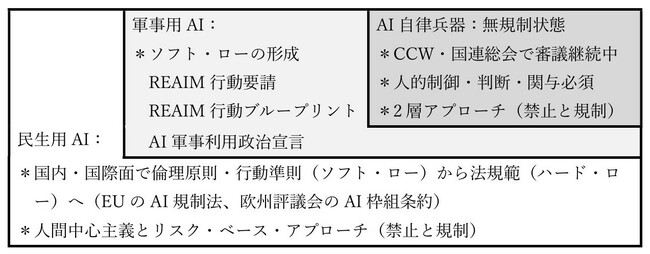

軍民両用のAIは、人間の諸活動での利便性の向上という利点と予測不可能な潜在的リスクを併せ持つことから、民生領域・軍事領域全般・兵器領域の3領域において、研究開発の促進と許容範囲の規制が同時進行している。3領域でのAI使用の規制状況を踏まえ、AI兵器規制の現状と今後の展望を考える。【表1:AI利用領域と規制状況】参照。

民生用AIの規制動向:「ソフト・ロー」から「ハード・ロー」へ

民生用AIの規制は、2019年以降、国際社会で活発に議論されてきた。G7、G20、EU(欧州連合)、OECD(経済協力開発機構)およびUNESCO(国連教育科学文化機関)は、採択文書において、主体は人間であり、AIは補完的役割に徹し人間の監視下に置かれると規定した(人間中心アプローチ)。それらに共通する内容は、バイアスを軽減する公平性、AI本体の安全性や信頼性、不具合の究明のための透明性や追跡可能性、不具合を解除・停止する制御可能性、そして、AI使用における人間の責任性である。また、AIリスクの程度に応じて禁止と規制に分けるリスク・ベース・アプローチが採用された。ただし、それらの文書は、国際条約の法文書(ハード・ロー)でなく、倫理規範や原則指針などの非法文書(ソフト・ロー)の形式で規定された。

最近では、2023年のG7広島AIプロセス包括的政策枠組み、2023(英)・24(韓)・25(仏)年開催のAIサミットでの諸宣言および生成AIにも対応する2024年のOECD改定AI原則、さらに、2024年にAI利活用に関して初の国連総会決議が採択された。民生用AI規制に関するソフト・ローは、徐々に蓄積している。

他方、2024年5月に欧州評議会が欧州AI枠組条約を採択し、同年8月にEUの欧州AI規制法が発効したように、AI関連のハード・ローが策定された。日本を含む各国も、現実のAIリスクに対処すべく国内法制定に取り組み始めた。国際的にも国内的にも、民生用AI規制は、徐々にソフト・ローからハード・ローへと向かう傾向にある。

軍事用AIの規制動向:ここ数年で「ソフト・ロー」は充実

AIは、軍事作戦、指揮統制、諜報・監視・偵察、情報処理、兵站支援などあらゆる軍事領域で活用可能である。前述のAI意思決定支援システムを含めて、軍事用AIが既に実戦使用されている現状から、この問題が国際会議で取り上げられるようになった。2023年2月に「軍事領域での責任あるAIサミット:REAIM 2023」は「REAIM行動要請」(60カ国賛同)を、翌年9月の第2回REAIMサミットは「REAIM行動ブループリント」(61カ国賛同)を策定した。両文書とも、非法文書形式でAIの軍事利用に関する現状認識と国家が取るべき責任あるAI行動を提示している。軍事領域での責任あるAIの履行として、人間中心主義、国際法の遵守、人間の説明責任、誤作動防止の安全装置の確立、AIの開発・配備・使用における人間の適切な関与、効果的な法的審査、信頼醸成措置およびグッド・プラクティスの情報交換などが規定されている。

同様に、2023年11月の米国提唱による「AI軍事利用政治宣言」(58カ国賛同)も、非法文書形式で軍事用AIの開発・配備・使用の指針として位置付けられた。さらに、国連も2024年に軍事領域でのAIに関する初の総会決議を採択し、それを次年度の議題に挙げることにした。

このように、軍事領域での責任あるAIの利用についてのソフト・ローが、この2~3年で急速に水平的(賛同国の増加)・垂直的(規定内容の拡大)に充実しつつある。

AI兵器の規制動向:4つのグループに分かれて意見が対立

では、AI兵器の規制はどうか。

「フォーサイト」は、月額800円のコンテンツ配信サイトです。簡単なお手続きで、サイト内のすべての記事を読むことができます。